Cuando un ser humano ve una molécula rotada o un objeto reflejado en un espejo, puede reconocerlos como la misma entidad. Para los modelos de aprendizaje automático, sin embargo, este tipo de simetrías —como traslaciones, rotaciones o permutaciones— pueden ser un verdadero desafío. Y esto no es un simple tecnicismo: si un modelo no entiende la simetría, puede llegar a conclusiones erróneas, desperdiciar capacidad computacional o requerir más datos de los necesarios.

Un nuevo avance del MIT ha logrado romper una de las barreras teóricas y prácticas más relevantes en este campo: ¿es posible entrenar modelos de aprendizaje automático que respeten la simetría de forma garantizada y eficiente? La respuesta, por primera vez, parece ser que sí.

El problema de la simetría en los datos

Los datos simétricos abundan en la naturaleza. Un ejemplo clásico es el de las moléculas, cuya estructura tridimensional es idéntica bajo ciertas rotaciones. También lo vemos en imágenes, donde un objeto sigue siendo el mismo aunque cambie su orientación o posición. En términos técnicos, esto se conoce como invariancia o equivariancia a ciertas transformaciones.

Sin embargo, la mayoría de los modelos de aprendizaje automático no están diseñados para reconocer explícitamente estas simetrías. Esto puede llevar a:

Sobreajuste a representaciones específicas de los datos.

Necesidad de más datos para cubrir todas las variantes posibles.

Mayor coste computacional al tener que procesar versiones redundantes.

Un enfoque común para abordar este problema es el aumento de datos, en el que se generan múltiples versiones transformadas del mismo ejemplo. Pero esto solo resuelve el problema parcialmente y con un alto coste de entrenamiento. Otra alternativa es diseñar arquitecturas que respeten simetrías de forma nativa, como las redes neuronales gráficas (GNN), que han demostrado ser efectivas, aunque difíciles de interpretar y analizar desde una perspectiva teórica.

El avance del MIT: teoría sólida y eficiencia práctica

Un equipo de investigadores del MIT, liderado por Behrooz Tahmasebi, Ashkan Soleymani, Stefanie Jegelka y Patrick Jaillet, ha presentado el primer método garantizado para aprendizaje automático con simetría que es eficiente tanto en cómputo como en requerimientos de datos.

Su trabajo se basa en una comprensión teórica profunda de las compensaciones estadístico-computacionales que surgen cuando se busca incorporar simetría en el aprendizaje. En esencia, hay un trade-off: si queremos modelos que requieran menos datos, debemos pagar con mayor complejidad computacional, y viceversa.

Lo innovador de su enfoque es cómo lograron superar esta tensión, diseñando un algoritmo que combina herramientas del álgebra y la geometría para representar y explotar las simetrías de manera estructurada.

¿Qué hicieron exactamente?

Algebraicamente, simplificaron el espacio de hipótesis considerando las transformaciones que no cambian el significado de los datos.

Geométricamente, representaron esas simetrías de forma que puedan ser manipuladas computacionalmente.

Combinación eficiente, reformulando el problema como una tarea de optimización sobre estructuras matemáticas que preservan la simetría.

Este enfoque reduce significativamente el número de ejemplos requeridos para entrenar modelos precisos y generalizables.

Aplicaciones y futuro

El impacto potencial de este avance es amplio:

Descubrimiento de fármacos, donde las moléculas se representan como grafos con simetrías estructurales.

Climatología y astronomía, donde los patrones globales a menudo son invariantes a la ubicación.

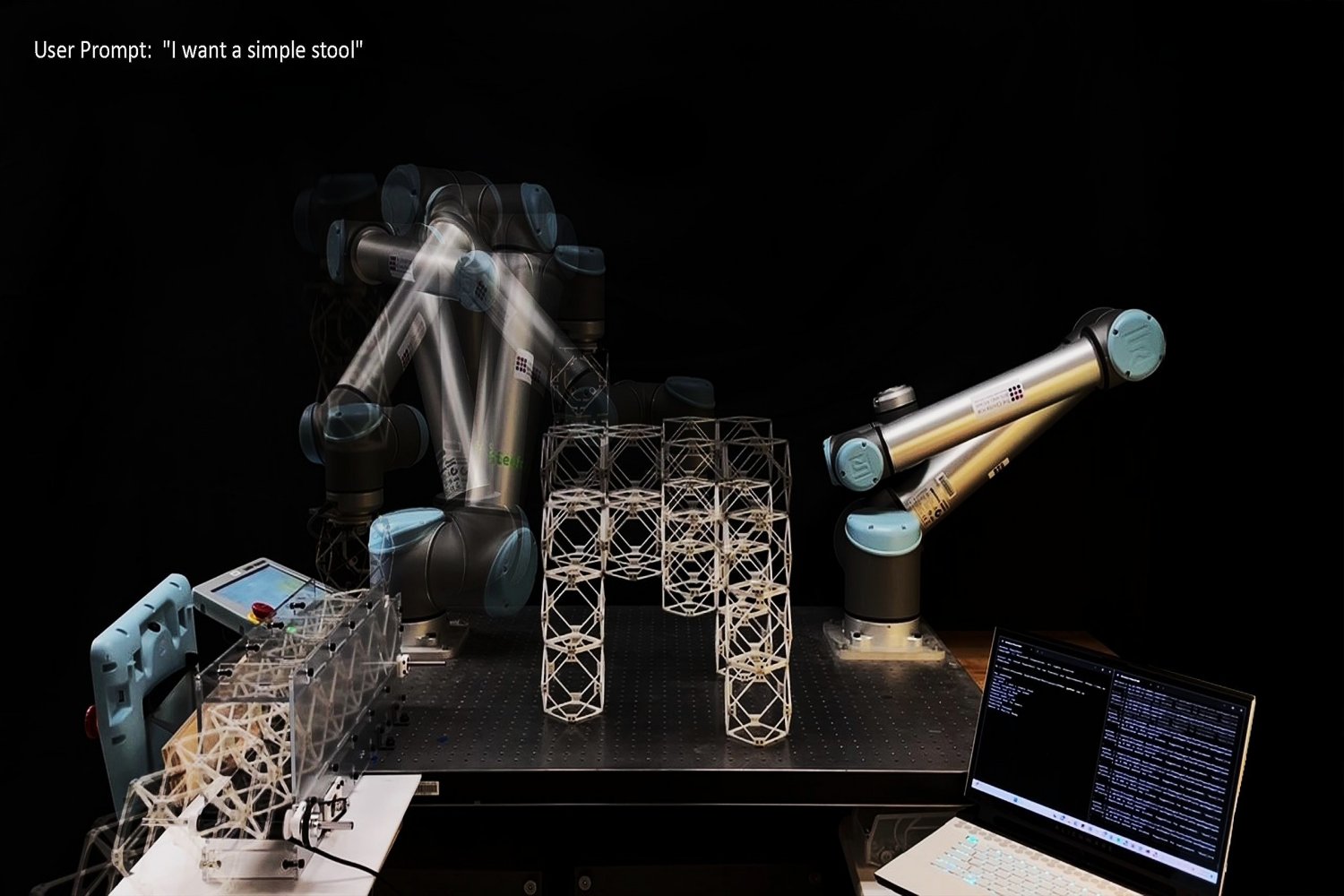

Robótica y visión por computadora, donde los objetos deben ser reconocidos en distintas orientaciones.

Además, los resultados de este trabajo abren la puerta a nuevas arquitecturas más interpretables, robustas y eficientes, lo que también podría ayudar a entender mejor cómo y por qué funcionan modelos como las GNN.

Más allá del modelo: entender las simetrías como conocimiento incorporado

Este avance también invita a una reflexión más general sobre el aprendizaje automático: los datos no lo son todo. Muchas veces, el conocimiento previo sobre la estructura del problema —como las simetrías— puede y debe incorporarse en los modelos. Esto no solo mejora la eficiencia, sino también la transparencia y la seguridad de los sistemas inteligentes.